はじめに

クラウド推進チームでは、AWSを用いたサービスの設計書がAWSベストプラクティスに準拠しているかを確認するためのチェックリストを運用しています。

しかし、100項目以上にわたるチェック項目を手動で確認するには約6時間もの時間を要していました。

そこで、この作業をAI Agentを用いて自動化することに挑戦しました。

目次

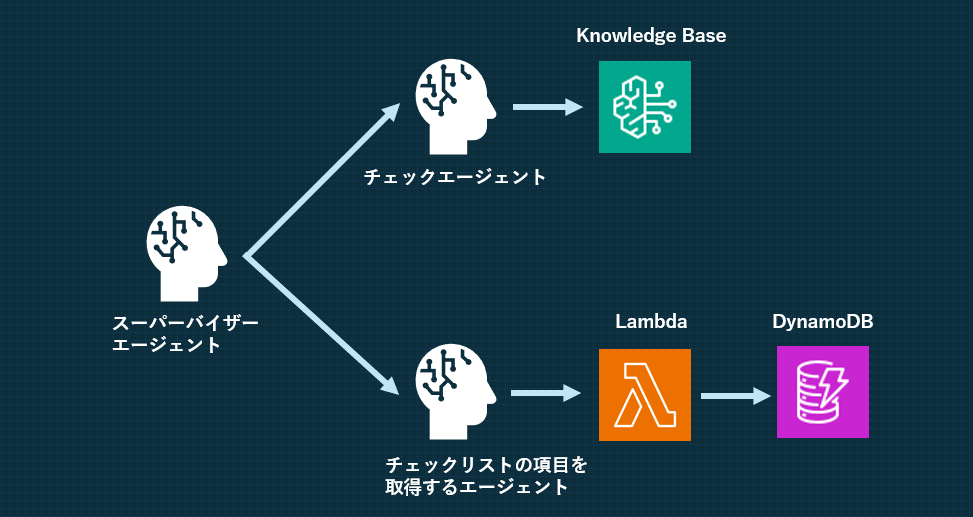

システム構成

今回構築したシステムは、スーパーバイザーエージェント、チェックリストの項目を取得するエージェント、チェックエージェントの3つのエージェントで構成されています。

チェックリストの項目を取得するエージェントではLambda関数を使用してDynamoDB内に格納されているチェックリストの項目を取得します。

チェックエージェントではKnowledgeBaseを使用して設計書がチェック項目に準拠しているのかを確認します。

スーパーバイザーエージェントではこれらのエージェントを統括し、それぞれのエージェント間とユーザーとのやり取りを仲介します。

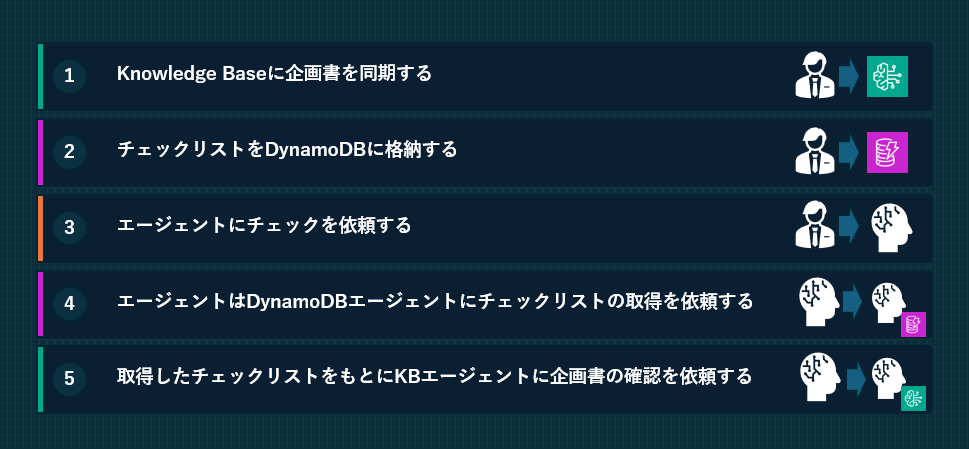

処理フロー

システムの動作は以下の5つのステップで構成されています。

初めに、ユーザーはチェックしたい企画書をKnowledge Baseに同期し、チェックリストをDynamoDBに格納します。その後、エージェントにチェックを依頼します。

初めに、ユーザーはチェックしたい企画書をKnowledge Baseに同期し、チェックリストをDynamoDBに格納します。その後、エージェントにチェックを依頼します。

チェックを依頼されたエージェントは、まずDynamoDBからチェックリストの内容を取得します。

次に、取得したチェックリストを基にKnowledge Baseエージェントに企画書の確認を依頼します。

確認結果を受け取ったら、その内容を整理してユーザーに返答し、チェックを完了します。

パフォーマンス評価

1項目あたりの処理時間は約40秒で、100項目以上のチェック項目を約1時間で完了できるようになりました。

従来の手動確認では約6時間を要していたため、6倍程度の効率化を達成しました。

課題点と対策

主な課題点

待ち時間の問題

チェックエージェントの準備に約10分程度の待ち時間が必要になります。AIの知識限界

「本番環境で利用されているAWSサービスがすべて網羅されているか」などの設計書だけでは判断が難しい項目の判定を苦手としています。結果管理の改善余地

現在はチェックの結果をチャット形式で返答していますが、そのため表にまとめるには手動での作業が必要です。

今後、エージェントが表にまとめて出力できるようになればさらに利便性が向上すると考えています。

「AIの知識限界」の対策

AIの知識限界」に関して、結果を出力時に「確実性」を生成させることで対策しました。

エージェントにチェック項目について、提供されている情報から確実な回答を生成できるかを判断させます。

提供された情報だけでは確実な回答の生成が困難だと判断した場合、チェック結果に「要確認」のステータスと関連情報が記載されているページ番号を出力することで、人による二次確認の効率化を図りました。

さいごに

今回の取り組みを通じて、AI Agentによる業務自動化の実用性を実感できました。完璧ではないものの、適切な設計と運用により十分に実用化可能なレベルに達していると感じています。

このブログをお読みいただいた皆様も、日々の業務において「この作業、生成AIで自動化できないだろうか?」という視点を持ってみてはいかがでしょうか。

一見自動化が難しそうに思える業務でも、アプローチを工夫することで効率化できる可能性があります。皆様の職場にも、生成AI活用のヒントが隠れているかもしれません。

また、この検証を行う上でMultiAgentの仕様による予期せぬコストのスパイクが起こってしまいました。

次の記事ではそのコストのスパイクの原因と対策方法について簡単にご紹介いたします。